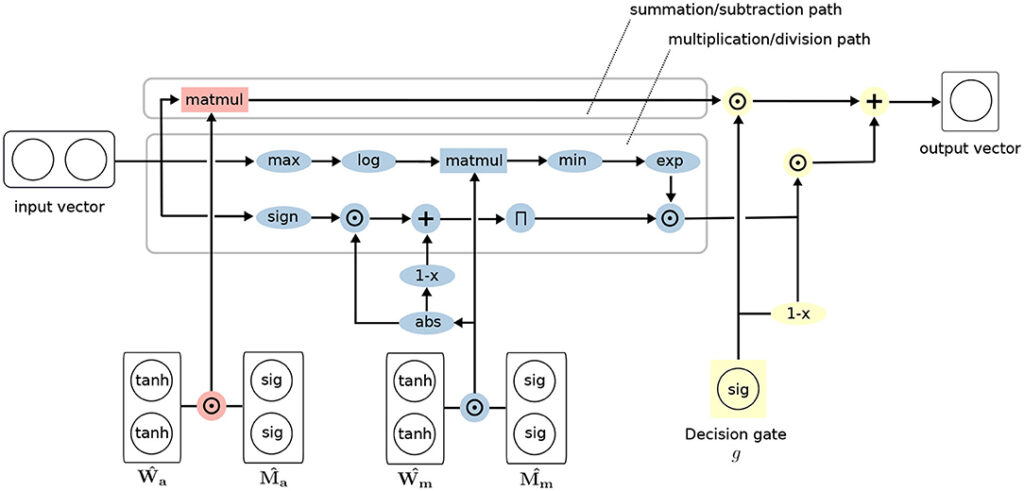

Im Projekt Deepscan werden komplexe Neuronale Netz Architekturen für die Erkennung von Anomalien entworfen und getestet. Neuronale Netze müssen mathematische Beziehungen erfassen, um verschiedene Aufgaben zu lernen. Sie approximieren diese Beziehungen implizit und lassen sich daher oft nicht gut verallgemeinern. Die kürzlich vorgeschlagene Neural Arithmetic Logic Unit (NALU) ist eine neuartige neuronale Architektur, die in der Lage ist, die mathematischen Beziehungen durch die Einheiten des Netzes explizit darzustellen, um Operationen wie Summation, Subtraktion oder Multiplikation zu lernen. Obwohl NALUs bei verschiedenen nachgelagerten Aufgaben nachweislich gute Leistungen erbringen, offenbart eine eingehende Analyse praktische Konstruktionsmängel, wie die Unfähigkeit, negative Eingabewerte zu multiplizieren oder zu dividieren, oder Probleme mit der Trainingsstabilität bei tieferen Netzen. Daniel Schlör1*, Markus Ring2 und Andreas Hotho1 gehen diese Probleme an und schlagen eine verbesserte Modellarchitektur vor. Sie evaluierten das Modell empirisch in verschiedenen Situationen, vom Erlernen einfacher arithmetischer Operationen bis hin zu komplexeren Funktionen. Die durchgeführten Experimente zeigen, dass die iNALU Stabilitätsprobleme löst und das ursprüngliche NALU-Modell in Bezug auf arithmetische Präzision und Konvergenz übertrifft.

Abb. 1.: iNALU Architektur

Das komplette Paper kann in Frontiers in Artificial Intelligence gelesen werden:

https://www.frontiersin.org/articles/10.3389/frai.2020.00071/full